Camille CasteraInertial and Second-order Optimization Algorithms for Training Neural Networks

Camille est actuellement chercheur à l'Université de Tübingen en Allemagne. Il a consacré sa thèse à l'optimisation des réseaux neuronaux.

Camille est actuellement chercheur à l'Université de Tübingen en Allemagne. Il a consacré sa thèse à l'optimisation des réseaux neuronaux.

Il a obtenu son doctorat au laboratoire IRIT de Toulouse sous la supervision de Cédric Févotte, Édouard Pauwels et Jérôme Bolte.

Son travail a des implications majeures dans le domaine des modèles basés sur les réseaux neuronaux, qui ont connu une popularité croissante ces dernières années

Sa thèse est disponible en ligne:

https://www.theses.fr/2021INPT0107

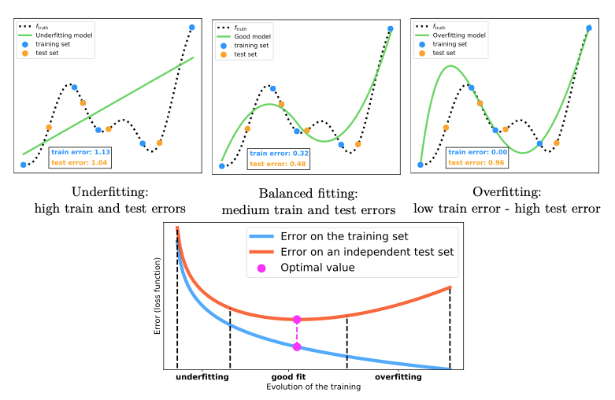

Les modèles de réseaux neuronaux sont devenus très prisés pour leur efficacité dans diverses applications. Cependant, la phase cruciale d'entraînement, qui implique le réglage des nombreux paramètres du modèle, est coûteuse en termes de temps de calcul et de ressources. Camille s'est attaqué au de l'entraînement des réseaux neuronaux en développant de nouvelles approches mathématiques. Les résultats théoriques de Camille sont étayés par des expériences numériques prometteuses sur des problèmes d'apprentissage profond. Son travail trace une voie novatrice, reliant la théorie mathématique à des applications pratiques, ouvrant ainsi de nouvelles perspectives pour l'optimisation des réseaux neuronaux.

Les points forts de sa thèse

Optimisation Mathématique d'Envergure :

Mathématiquement, l'entraînement d'un réseau neuronal équivaut à résoudre un problème d'optimisation à grande échelle, impliquant la minimisation d'une somme de fonctions. Les algorithmes standards utilisent généralement des gradients inexacts, limitant les choix d'algorithmes disponibles. Camille a exploré des alternatives en exploitant des informations du second ordre par le biais d'une différenciation automatique du premier ordre bruitée.

INNA - Un Nouvel Algorithme Dynamique :

Camille a introduit INNA, un algorithme inertiel et newtonien, basé sur un système dynamique (une équation différentielle ordinaire). En analysant ce système dynamique conjointement avec INNA, il a démontré la convergence de l'algorithme vers les points critiques de la fonction à minimiser, prouvant ensuite que ce résultat constitue effectivement un minimum local avec une probabilité écrasante.

Step-Tuned SGD - Ajustement Automatique des Pas :

Une autre contribution majeure est Step-Tuned SGD, un algorithme qui ajuste automatiquement les pas de la descente de gradient stochastique (SGD). Cette adaptation intelligente de la sous-échantillonnage mini-batch permet une discrétisation efficace de l'information du second ordre. Les résultats théoriques sont solides, avec la convergence presque sûre de Step-Tuned SGD vers les points critiques, accompagnée de taux de convergence.