Alban GossardMéthodes d’apprentissage pour l’IRM computationnelle

Diplômé du département de mathématiques appliqué, Alban effectué sa thèse avec Pierre Weiss et Frederic De Gournay. Sa thèse explore divers aspects liés à l'apprentissage appliqué à l'Imagerie par Résonance Magnétique (IRM) computationnelle. Il a apporté une contribution significative à l'avancement des connaissances dans ce domaine, en s'attaquant à des défis complexes tels que l'optimisation des schémas d'échantillonnage, la formation de réseaux de neurones adaptatifs et les méthodes d'optimisation générale pour ces réseaux.

Diplômé du département de mathématiques appliqué, Alban effectué sa thèse avec Pierre Weiss et Frederic De Gournay. Sa thèse explore divers aspects liés à l'apprentissage appliqué à l'Imagerie par Résonance Magnétique (IRM) computationnelle. Il a apporté une contribution significative à l'avancement des connaissances dans ce domaine, en s'attaquant à des défis complexes tels que l'optimisation des schémas d'échantillonnage, la formation de réseaux de neurones adaptatifs et les méthodes d'optimisation générale pour ces réseaux.

Sa thèse est disponible en ligne:

https://www.theses.fr/2022TOU30209

Ces réalisations ouvrent la voie à des améliorations notables dans la reconstruction d'images, l'optimisation des schémas d'acquisition et la formation de réseaux de neurones, marquant ainsi une contribution importante à l'évolution continue du domaine de l'imagerie computationnelle.

Points forts de sa thèse:

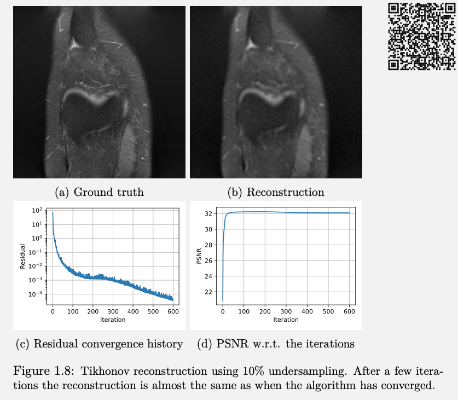

Optimisation de l'échantillonnage en IRM : Les travaux d'Alban ont approfondi l'analyse des défis liés à l'optimisation des schémas d'échantillonnage de Fourier en IRM. En examinant les minimiseurs parasites, ils ont apporté un nouvel éclairage sur des problèmes cruciaux liés à la conception de schémas d'échantillonnage optimaux.

Globalisation de la convergence : Pour accroître l'efficacité de l'optimisation des schémas de Fourier, ses travaux ont introduit une méthode novatrice de globalisation de la convergence. Cette approche a permis de réduire considérablement les coûts numériques tout en améliorant la qualité des images reconstruites.

Stabilité des réseaux de neurones : En traitant de la stabilité des réseaux de neurones, Alban a démontré que les réseaux unrolled peuvent gagner en stabilité. Ils ont également montré que la formation de ces réseaux sur une famille d'opérateurs permet de résoudre plusieurs problèmes inverses aveugles.

Optimisation automatique des hyperparamètres : L'introduction d'un algorithme pour calculer la courbure d'une composition de fonctions a permis une optimisation automatique des hyperparamètres lors de l'entraînement de réseaux de neurones. Cela représente une avancée significative vers une automatisation plus poussée des processus d'apprentissage

Sa page web

https://albangossard.github.io